「便スキャン」搭載便器「ネオレストLS-W/AS-W」

TOTO株式会社は、新機能「便スキャン」を搭載したウォシュレット一体形便器「ネオレストLS-W」「ネオレストAS-W」を2025年8月1日(金)から日本国内で発売すると発表しました。めちゃくちゃ興味深いです!

詳しくはこちら。

性能の概要は以下の感じ。

「便スキャン」は、ウォシュレットに内蔵した便スキャンセンサーで落下中の便をスキャンし、便の形(硬さ)・色・量を自動で計測する機能です。

ウォシュレットのノズル出口の隣に内蔵されている「便スキャンセンサー」で計測します。

LEDの光を落下する便に向かって投光し、便からの反射光をセンサーで受光します。これを繰り返すことで、便の形(硬さ)、便の色、便の量が計測できます。

便の形(硬さ)

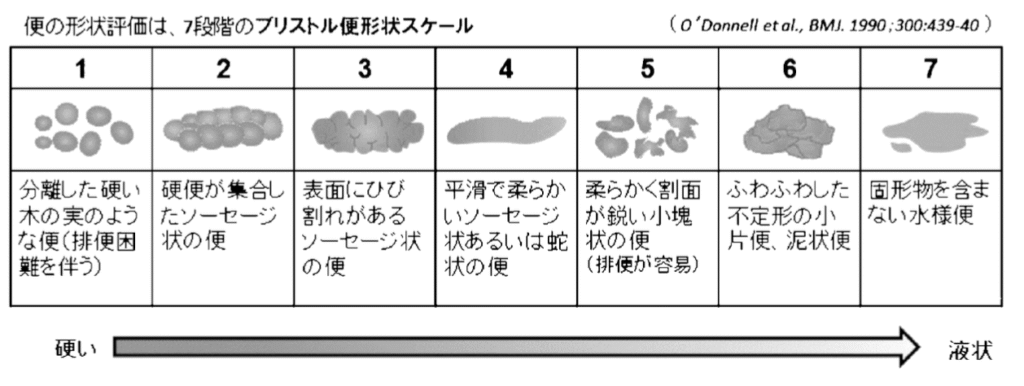

便の長さや幅、輪郭、表面情報などを元に、ブリストル便性状スケールを参考にTOTOが作成した独自の分類方法で7タイプに分類します。

便の量

便の長さや幅、落下する時間情報などを元に、100グラム相当未満を少、100グラム相当から300グラム相当を中、300グラム相当を超えるものを多とする3つに分類します。

便の色

便の明るさの情報を元に、黄土系、茶系、焦げ茶系の3つに分類します。

性能的には、まだまだ物足りない印象はありますが、初めの第一歩と考えれば大いに楽しみなシステムです。

学術的には、この分野はどのような動向なのか少し調べてみました。2021年のデューク大学による論文をご紹介します。

はじめに:排泄行動が語る健康の真実

日々の健康状態を高精度で可視化する「プレシジョンヘルス」への関心が高まる中、便や尿といった排泄物の分析が注目されています。中でも「スマートトイレ」は、ユーザーが意識することなく、排泄行動から生理的・病理的情報を長期間にわたり自動収集できる革新的な装置です。本論文は、スマートトイレに搭載された画像解析技術により、便の形状分類と肉眼的血液(gross blood)の検出を同時に可能とする機械学習アプローチを提案したものです。

従来、便の記録は患者自身の主観的な報告に依存しており、再現性や正確性に課題がありました。しかし、便の色や形状、血液の混入といった視覚的特徴は、過敏性腸症候群(IBS)や炎症性腸疾患(IBD)、上部消化管出血など多くの疾患の診断補助情報として極めて有用です。こうした臨床的意義を踏まえ、本研究では3,275枚の便画像を用いて機械学習モデルを訓練し、スマートトイレによるリアルタイムかつ客観的な便分析の可能性を探りました。

スマートトイレとその画像取得技術

本研究で用いられたスマートトイレは、排泄後に便が流れる配管部に設置された内視鏡カメラとLED照明により画像を取得します。この設計により、ユーザーは装置の存在を意識せず、日常の使用感を損なうことがありません。また、フラッシュボタンに内蔵された指紋認証機能により、複数ユーザーの識別が可能となっており、家庭内での個別追跡や縦断的モニタリングにも対応しています。

画像はRaspberry Pi 3B+により処理され、便の形状分類および血液検出を行うためのCNN(畳み込みニューラルネットワーク)へ送られます。従来のCNNでは高い演算資源を必要とするため、モバイル環境にも対応可能な軽量ネットワークとしてMobileNetV2およびShuffleNetV2を採用しています。

便画像データセットの構築とアノテーション

臨床情報を伴う公開便画像データベースが存在しないことから、研究チームは独自に3,629枚の画像を収集しました。画像の内訳は、Web上から2,720枚、一般参加者からの匿名アップロードが909枚であり、画像の質的審査を経て最終的に3,275枚が研究対象とされました。

そのうち552枚は2名の消化器内科医が独立にBSFSスコアを付与し、Cohen’s Kappa統計量はBSFS分類で0.435、3分類(便秘・正常・下痢)で0.540と中等度の一致を示しました。これは、医師間の評価のばらつきを示すものであり、便という生体サンプルの異質性を考慮すれば妥当な結果といえます。

便形状分類モデル:MobileNetV2による階層型CNNの設計

便形状は、Bristol Stool Form Scale(BSFS)に従って1〜7型に分類されますが、例えば3型と4型は視覚的に極めて類似しており分類が困難です。

(図の出典:日本公衆衛生雑誌 2021; 68(2): 92-104.)

こうしたクラス間の視覚的分離の難しさを克服するため、本研究では階層型CNN構造を導入しています。まず「便秘(1,2型)」「正常(3,4,5型)」「下痢(6,7型)」の3分類(coarse classification)を行い、その後、対応する詳細分類(fine classification)に進む2段階の構造です。

さらに、データのクラス不均衡(例:正常便の画像数が多い)への対策として、「class-balanced softmax cross-entropy loss」を用い、各クラスの学習重みを調整しています。MobileNetV2を用いたモデルでは、以下のような性能を示しました。

- 3分類のbalanced accuracy(BA):81.66%

- 7分類のBA:54.58%

- ROC-AUC(3分類):いずれも0.91以上

- 推論時のFLOPs:0.35 GFLOPs

- メモリ要件:15.6 MB

従来のGoogleNet Inception v3を使用した研究と同等の精度でありながら、わずか15.6MBのメモリ使用量と0.35GFLOPsという低リソースで実現した点が画期的です。これはラズベリーパイのような小型コンピュータでの実装を可能にします。

血液検出:色空間量子化と決定木による解析

便中の血液は、その色調(鮮血、暗赤色、黒色)によって出血源の推定に用いられます。単純な色閾値では検出が不正確なため、本研究ではCIE LAB色空間とISCC-NBS色辞書に基づく色量子化を導入し、”red”および”black”を含む色名を抽出しました。

代表的特徴量の選択にはMutual Information(相互情報量)を用い、最も情報量の多い色特徴を選抜しています。その上で、分類器として決定木(DT)およびk近傍法(KNN)を比較検討した結果、決定木が安定して高性能を示しました。

- クラウドソース画像(Dataset B)におけるBA

- DT:74.64%

- KNN:73.00%

- Web画像(Dataset A)におけるBA

- DT:62.82%

- KNN:58.45%

Web画像の精度が相対的に低いのは、解像度や照明条件が不統一であるためと考えられます。

従来の色閾値処理では困難だった、便に混ざった血液の不均一な表現(凝血塊から暗赤色・黒色便まで)に対応できる点が臨床的に重要です。血液の色調は出血部位の同定に有用な情報(鮮紅色は遠位腸管、暗赤色は大腸、黒色タール便は胃・上部小腸出血を示唆)を提供します。

新規性

この研究の最大の新規性は、スマートトイレという非侵襲的かつ受動的なインフラに、軽量で階層的な機械学習モデルを統合し、リアルタイムで便の客観的評価を可能にした点にあります。また、従来の研究と比較して、(1)より大規模なデータセット、(2)クラス不均衡への対応、(3)リソース制約下での運用可能性、という点で一歩進んだ成果です。

臨床的意義と実践的応用

この技術がもたらす臨床的メリットは多岐にわたります。まず、患者の主観的報告に依存せず、客観的な便性状データを長期にわたって収集できます。臨床現場では、BSFSタイプ3-5を「正常」、1-2を「便秘」、6-7を「下痢」と分類しますが、本研究のシステムはこの臨床的分類を81.7%の精度で自動化できます。

実践的な応用として、以下のような活用が考えられます:

- 過敏性腸症候群(IBS)患者の食事トリガーの特定(特定食品が症状を悪化させるパターンの発見)

- 下痢止めや緩下剤の効果モニタリング

- 炎症性腸疾患(IBD)フレアアップの早期発見(血性下痢の検出)

- 上部・下部消化管出血の鑑別(血液色調の分析)

家庭用トイレにこのシステムを導入すれば、ユーザーは特別な操作なしに日常的な健康モニタリングが可能になります。医師は経時的なデータを参照し、より個別化された治療計画を立てることができるでしょう。

Limitation(限界)

- 使用した画像には臨床的背景情報(診断、症状、治療歴)が伴っておらず、疾患特異性の評価は未実施です。

- BSFS評価などアノテーションは医師による主観的評価であり、完全な客観性を保証するものではありません。

- 一部の分類(特にBSFS 4と5型)は混同されやすく、さらなるモデル精度の向上が必要です。

おわりに:明日から活かす「排便観察」の意義

本研究の成果は、便という日常的でありながら強力なバイオマーカーを、ユーザーの負担なく高精度に可視化する可能性を示しました。医療者にとっては、主観に依存しない客観的データの取得が可能となり、予防・介入・治療評価に新たな視点をもたらすでしょう。

今後、スマートトイレとAI技術が臨床現場と家庭の橋渡しとなる時代が到来するかもしれません。

参考文献

Zhou, J., DeCapite, N., McNabb, J., Ruiz, J. R., Fisher, D. A., Grego, S., & Chakrabarty, K. (2021). Stool Image Analysis for Precision Health Monitoring by Smart Toilets. Proceedings of Machine Learning Research 149:1–20.