はじめに

2025年、アメリカ連邦議会で検討されている「健康技術法(The Healthy Technology Act of 2025)」は、医療界に衝撃を与えています。この法案が可決されれば、AIシステムが人間の医師による最終確認なしに、独立して処方箋を発行することが許可されるからです。すでに大規模言語モデルは、日常的に診断や治療の意思決定支援に用いられていますが、この法案はAIが「自律的な臨床実践者」へと脱皮する道筋を示しています。

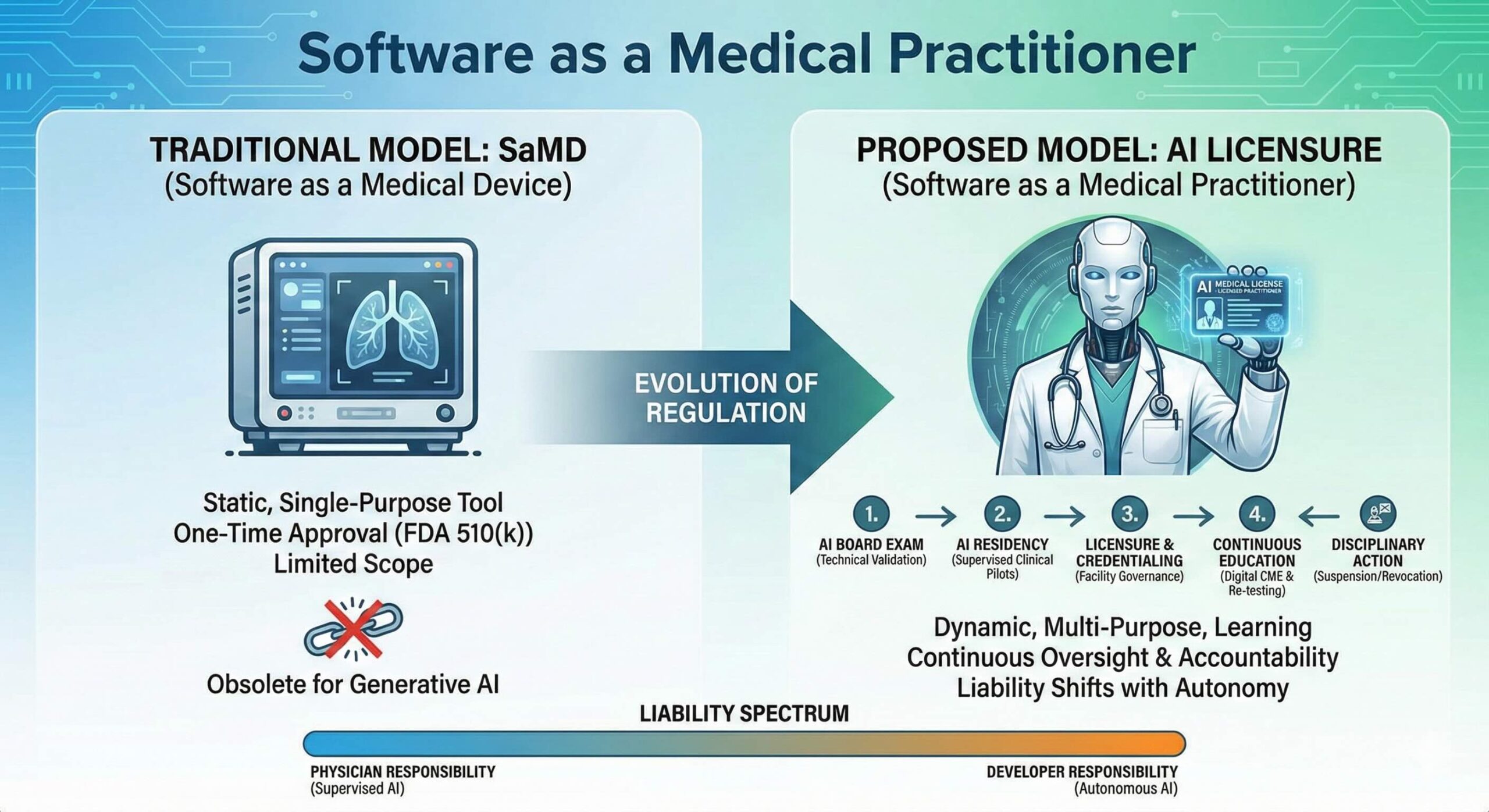

しかし、ここで深刻な問題が浮上します。これまで臨床用AIを規制してきた既存の枠組みは、主に「医療機器としてのソフトウェア(SaMD: Software as a Medical Device)」という概念に依存してきました。FDA(米食品医薬品局)はすでにこの枠組みを用いて1000以上のAIツールを承認してきましたが、その多くは特定の、極めて限定的なタスクをこなすためのものでした。一方で、汎用的な生成モデルの出現は、この「機器」という定義そのものを引き裂こうとしています。

SaMDという限界:なぜ「機器」としての規制は破綻するのか

FDAがこれまで実施してきたSaMDの承認プロセスのうち、95%以上が「510(k)」と呼ばれる経路、すなわち既存の類似製品(プレディケート)との実質的同等性を証明する手法をとってきました。これは、ペースメーカーや車椅子のようなハードウェアを想定したモデルです。しかし、著者たちは、生成AIにはこのパラダイムが通用しない3つの致命的な理由を挙げています。

アルゴリズムの動的な性質

第一に、アルゴリズムの動的な性質です。従来の規制は「静的な製品」を一度だけ審査することを前提としています。ところが生成AIは、トレーニング、微調整、検索(RAG)、ポリシーの更新などを通じて、導入後もその挙動が絶えず変化します。一回限りの審査では、その後の性能の変化を捉えきれません。

適応範囲の広さ

第二に、適応範囲の広さです。SaMDは「高リスクの肺病変を分類する」といった狭い用途を前提とします。しかし、一つの生成AIモデルが、CTスキャンの解釈、バンコマイシンの投与量設計、不妊治療のカウンセリングを同時にこなすことが可能です。全てのユースケースを事前に規定し、承認することは事実上不可能です。

製造者のコントロール、規制上の責任

第三に、製造者のコントロールの問題です。

「製造者のコントロール(Manufacturer Control)」とは、医療用ソフトウェアの開発・販売元が、その製品の設計、データ、アルゴリズム、そして最終的な出力結果に対して、完全に把握し、管理・監督できる状態にあることを指します。

現代のモデルはオープンウェイトの基盤モデルをベースにし、そこにローカルな微調整やサードパーティのプラグインが組み合わされます。例えば、現在の多くの医療用生成AIアプリは、自社でゼロからモデルを作っているわけではありません。OpenAI (GPT-4) や Google (Gemini) などが開発した巨大な「基盤モデル」をAPI経由で利用しています。

これにより、誰が最終的な規制上の責任(オーナーシップ)を持つのかが極めて曖昧になっています。

臨床家としてのAI:ライセンス制度という新たな視座

ブレスマン博士らは、19世紀末に医療の質を保証するために誕生した「医師免許制度」をAIに応用することを提案しています。かつて未熟な訓練や紛い物の薬から公衆を守るために作られたこの仕組みは、現代のAIが抱える「ハルシネーション(幻覚)」※、「性能のドリフト」※、「データ毒入れ」※といった懸念に対処するための理想的な雛形となります。

具体的には、医師助手(PA)や診療看護師(NP)に適用されている「監督下での実践」や「共同実践」のモデルをAIに当てはめます。AIは、その機能(ノートの記述、薬の処方など)に応じて「制限付き実践フレームワーク」や、リスクの低い機能における「削減された監督下での実践」といったカテゴリーでライセンスを付与されることになります。

※ハルシネーション(Hallucination):生成AI、特に大規模言語モデル(LLM)が、もっともらしいが事実ではない、あるいは誤った情報を生成してしまう現象

※ 性能のドリフト (Performance Drift / Model Drift):AIが実社会の変化に追いつけず、時間の経過とともに精度が落ちていく現象

※データ毒入れ (Data Poisoning):悪意ある第三者が、AIの学習データに嘘の情報を混ぜ込み、AIを意図的に誤作動させる攻撃

AIレジデンシーと継続的な質保証:表に見る具体的実装案

提案されているライセンス制度は、人間が医師になるまでの過程を鏡のように映し出しています。

- 免許取得前要件(AIボード試験とレジデンシー)

開発者はまず、定義された能力について技術的検証を受ける必要があります。これがAI版の「医師国家試験(ボード試験)」です。その後、認定された「実装センター」において、監視付きのパイロット運用期間、すなわち「AIレジデンシー」を経験し、実地での適格性を証明しなければなりません。 - 施設によるクレデンシャル(資格認定)

ライセンスを持ったAIが病院に導入される際、各医療機関のAIガバナンス委員会がその現場特有の実装を審査します。特定の処置を行う特権(特権付与)を管理し、もし品質指標が閾値を下回れば、そのモデルの稼働を停止させる権限を持ちます。 - 継続的な監視(デジタルCMEとMOC)

免許は一度取れば終わりではありません。人間の医師が継続的医学教育(CME)を受けるように、AIも毎年更新されるベンチマークで再テストを受ける必要があります。これを著者らは「デジタルCME/MOC」と呼んでいます。 - 懲戒処分(デジタル懲戒委員会)

苦情を処理するための専門ボードが設置されます。不適切な動作が確認された場合、AIシステムを「保護観察」に置いたり、モデルのパッチ修正を命じたり、最悪の場合はライセンスを剥奪します。

責任の天秤:自律性と賠償責任の関係性

この議論において最も重要なのは「責任」の所在です。著者らは、AIの自律性の度合いに応じて責任の重さをスライドさせるべきだと主張しています。

制限付きライセンスの下でAIが動く場合、あるいは高リスクな機能を実行する場合、責任はそれを監視する臨床医と医療機関にあります。しかし、低リスクな機能においてAIに一定の自律性が与えられた場合、その責任(医療過誤の責任を含む)は開発者が負うべきです。この明確な境界線が引かれることで、AI専用の賠償責任保険市場が形成され、責任ある技術採用が加速すると考えられます。

本提案の新規性と課題

本研究(Viewpoint)の最大の新規性は、医療AIの規制を「製品(デバイス)の安全性」から「専門職(プラクティショナー)の資質管理」へとパラダイムシフトさせた点にあります。これまでの議論は、いかに精度を高めるかという技術論に終始しがちでしたが、本論文は社会システムとしての「信頼の担保」に焦点を当てています。

一方で、いくつかの限界(limitation)も存在します。

第一に、統治組織の構築が極めて複雑である点です。理想的には連邦レベルのデジタル免許委員会が必要ですが、アメリカの医療免許制度は州単位で管理されており、既存の50州の委員会とどのように調和させるかは大きな課題です。

第二に、責任の分配に関する法的根拠の未整備です。開発者が医療過誤責任を負うというモデルは、現在の製造物責任法や医療法の枠組みでは解決できない法的な摩擦を生む可能性があります。

第三に、本論文は「概念の提案」であり、具体的な性能評価のカットオフ値や、AIボード試験の具体的なプロトコールまでは定義していません。

私たちが明日から実践すべきこと

この論文から得られる教訓は、現場の臨床医や医療知識層が、今日から意識を変えるべきことを示唆しています。

まず、目の前のAIツールを「完成された不変の道具」と見なすのをやめてください。AIは、あなたの同僚であるレジデントや看護師と同じように、環境によって挙動が変わり、時には誤りを犯す「動的な存在」です。

次に、施設内でのガバナンスに積極的に関与してください。将来、あなたの病院でAIガバナンス委員会が設立される際、それは単なるIT部門の問題ではなく、臨床的な「特権管理」の問題になります。どのAIにどこまでの権限を与えるべきか、その基準を作るのは現場の知識を持つあなた自身です。

最後に、AIの出力を常にクリティカルに評価する姿勢を維持してください。免許制度が整うまでの間、最終的な「ライセンス」を持っているのはあなたです。AIの自律性が高まるほど、それを「監督する能力」が臨床医の最も重要なスキルセットになるでしょう。

生成AIの進化は止まりません。それを「機器」として箱に閉じ込めるのではなく、「実践者」として正しく教育し、管理し、責任を負わせる。この大胆な提案は、AIと共に歩むこれからの医療における、最も現実的な地図になるはずです。

参考文献

Bressman E, Shachar C, Stern AD, Mehrotra A. Software as a Medical Practitioner-Is It Time to License Artificial Intelligence? JAMA Intern Med. 2026;186(1):5-6. doi:10.1001/jamainternmed.2025.6132.